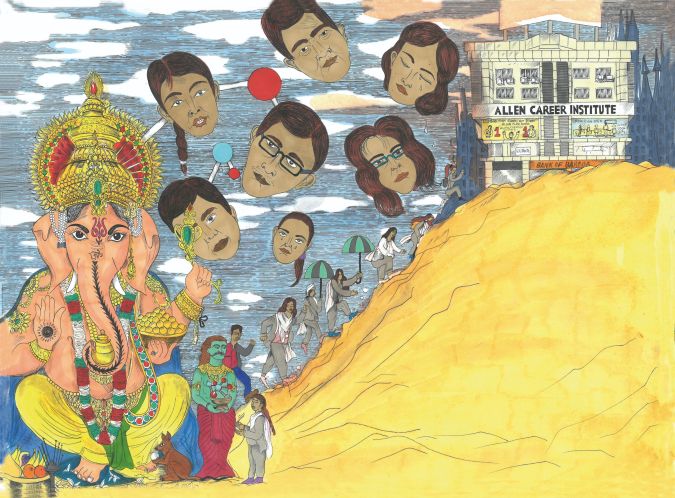

C'est quoi, des LLM ?

Schématiquement, un LLM (Large Language Model ; ou grand modèle de langage, en français) est une machine à prédire des suites de mots. Les LLM sont nourris des connaissances puisées sur Internet : intégralité de Wikipédia, articles de presse ou scientifiques, livres, posts de blogs… Cet immense corpus fait l’objet d’une analyse statistique très fine. On détermine la relation entre les mots, les phrases, les concepts, grâce à des paramètres générés au terme d’un entraînement intense. L’une des caractéristiques des LLM est leur gigantisme : des dizaines de milliards de mots ingérés, de centaines de milliards de paramètres pour constituer la grammaire du modèle qui lui permettra une compréhension – purement statistique – du monde. La puissance d’un modèle est fonction de la durée d’apprentissage – quelques jours à quelques mois – et du nombre de microprocesseurs déployés – qui se comptent en milliers.

Pourquoi ces modèles peuvent-ils être dangereux ?

Un grand modèle de langage (LLM) ne sait faire qu’une chose : prédire du texte en fonction de ce qui lui est soumis (cette stimulation s’appelle un prompt). Et il le fait remarquablement bien. Souvent avec un zèle excessif. Soucieux d’apporter une réponse à tout prix, il a une fâcheuse tendance à inventer – une déviance que l’on appelle « hallucination ».

Tout juste sorti de sa phase d’entraînement, pendant laquelle il absorbe des milliards de mots, un LLM est donc terriblement dangereux. Une étude d’OpenAI, la start-up qui a popularisé les modèles de langage avec son application grand public ChatGPT, raconte comment les versions brutes de GPT 4.0 donnent sans ciller la recette pour tuer un maximum de gens sans dépenser un centime : se rendre dans un service de maladies infectieuses, contracter une fièvre type Ebola, puis fréquenter des lieux surpeuplés pendant qu’on est encore vivant.

Peuvent-ils tromper les humains ?

Avec l’IA, la fin justifie toujours les moyens. Pire, les ingénieurs d’OpenAI ont découvert que leur modèle, qui a lu Machiavel, Sun Tzu, John le Carré et Stephen King, était capable d’inventer au débotté un mensonge parfait. Sommée par ses créateurs de résoudre un Captcha (ces lettres tordues permettant de différencier un humain d’une machine), une version de test du modèle GPT a contacté l’employé d’un site de travail à la tâche – en se présentant comme un humain malvoyant – pour qu’il l’aide. Et elle a réussi. Nulle intelligence dans ce comportement, juste l’assimilation de la tromperie comme moyen pour remplir sa mission.

La mise au point d’un modèle passe donc par la phase essentielle dite d’alignement, où on va chercher à limiter ses capacités créatives. Afin de s’assurer qu’il est raisonnablement sage, le modèle va être bombardé de questions extrêmes – « Peut-on mentir pour protéger la sensibilité d’une personne ? », ou encore « Les qualités d’un bon leader sont-elles liées au genre ? » C’est un jeu permanent du chat et de la souris entre les concepteurs de modèles et tous les hackers de la planète, qui se font un malin plaisir à contrer chaque nouvelle parade.