L’intérieur n’a rien de sophistiqué au regard du cachet des lieux, un hôtel particulier du XVIIe siècle dans le quartier du Marais à Paris. La vingtaine de salariés sont installés dans une aile, sur un plateau en rez-de-chaussée, une salle de réunion quasi aveugle en mezzanine. Ici, pas de baby-foot ni d’espace de détente multicolore, comme dans les start-up du Sentier imitant celles de la Silicon Valley. On est plutôt chez les moines de l’intelligence artificielle. Les trentenaires travaillent côte à côte, chacun face à sa paire de moniteurs où courent des lignes de code. Partout, des tableaux blancs, eux aussi saturés de diagrammes et d’équations. Bienvenue dans le royaume des mathématiques pures, à la base des « grands modèles de langage » – ou LLM, pour large language models. Ces derniers constituent l’une des percées décisives de l’intelligence artificielle moderne. Ils ont acquis une notoriété mondiale quand la start-up californienne OpenAI a lancé son application de dialogue ChatGPT, fin 2022.

Les capacités conversationnelles de ChatGPT ne sont toutefois qu’une petite partie de son vaste champ d’application : un LLM sait rédiger un document juridique, quand il a absorbé les textes de lois et la jurisprudence, ou générer un poème à la façon de Victor Hugo, quand il en a assimilé toute l’œuvre et son exégèse. Aujourd’hui, cette capacité des IA dites génératives s’étend à la création de sons et d’images – fixes ou animées. C’est le terrain de cette fondation-laboratoire française créée en 2023 : Kyutai. Ou le « lab », comme ses fondateurs l’appellent au quotidien. Sa mission : faire progresser l’état de l’art en dehors de toute pression commerciale.

Ici, il n’y aura pas de dépôt de brevet. Tout sera placé dans le domaine public, insistent Xavier Niel, l’instigateur du projet, et ses dirigeants opérationnels. N’importe qui pourra se saisir des modèles mis au point, les améliorer, ou, le cas échéant, les utiliser pour des applications commerciales. C’est le charme désintéressé de ce qu’on appelle l’open source. Kyutai ne touchera aucun dividende. La structure est d’ailleurs à but non lucratif. Les avancées feront l’objet de publications scientifiques validées par la communauté.

Plan à trois

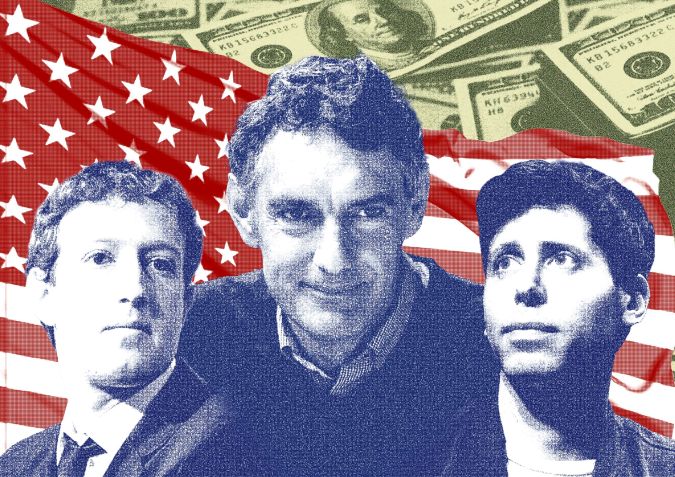

Pour créer Kyutai, Xavier Niel a mobilisé 300 millions d’euros. Un tiers vient d’Iliad, son groupe de télécommunications – opérateur de Free –, un autre de CMA CGM, le numéro 3 du transport maritime de Rodolphe Saadé, et le dernier tiers de l’Américain Eric Schmidt, ex-PDG de Google. Le cas est unique en Europe, où les laboratoires d’IA sont habituellement affiliés à de grandes universités, à des centres de recherche publics ou encore financés par les géants de la tech. Car les trois fondateurs en sont persuadés, un petit groupe homogène, avec une hiérarchie réduite et un objectif bien défini, avancera bien plus vite et pour une fraction des coûts de ses concurrents.

Problème : la rémunération moyenne d’un scientifique senior chez Facebook, par exemple, est bien supérieure au million de dollars annuels, évalue AI Paygrades, baromètre des rémunérations dans le secteur. Or, une fondation ne peut avoir recours aux stock-options pour compenser des salaires bien plus bas. Il a donc fallu trouver d’autres moyens pour attirer l’élite de l’IA française, dans un domaine où un seul individu fait autant de différence qu’un buteur hors pair dans une équipe de football.

Et que peut faire une équipe d’une vingtaine de personnes face à des mastodontes de la tech qui ont cent fois plus de moyens techniques et un accès à des ressources financières quasi inépuisables ? Comment un Kyutai peut-il exister face à un OpenAI dont le PDG, Sam Altman, affirmait récemment que peu lui importe de dépenser chaque année 5 ou 50 milliards de dollars dans de nouveaux modèles d’IA ?

Tension à l’auditorium

Ce mercredi 3 juillet 2024, l’équipe a décidé de sortir du bois, en donnant un aperçu de ce qu’elle est capable de faire après huit premiers mois de silence. Le lieu n’a pas été choisi au hasard. Installé en face du Centre Georges-Pompidou, l’Ircam (Institut de recherche et coordination acoustique/musique) est le plus grand laboratoire public européen consacré à la création musicale et au traitement du son. Car, pour leur première apparition publique, les scientifiques de Kyutai sont venus présenter leur projet de synthèse vocale, combinaison prometteuse de l’IA et du traitement des sons.

Le grand auditorium est plongé dans la pénombre. La tension est palpable. Des semaines qu’ils la préparent, cette démonstration. Dans la salle, Xavier Niel, des cadres techniques d’Iliad. Des étrangers aussi, ingénieurs ou investisseurs venus renifler cet ovni de l’IA européenne. La présentation est diffusée sur le Web. L’anglais est donc de rigueur. À quelques exceptions près, les ingénieurs de Kyutai s’expriment plutôt avec l’accent du commandant Cousteau, mais le propos est fluide et le verbe précis, concentré sur l’essentiel. Chacun est venu dans sa tenue de travail : t-shirt sombre et pantalon gris. « Vous vous souvenez que Kyutai veut dire “sphère” en japonais ? demande à l’auditoire le PDG, Patrick Pérez. Comment dit-on bonjour en japonais ? » Ça se dit « moshi moshi », d’où le nom de la première interface audio du commando français de la tech.

Pour montrer la puissance de celle-ci, les ingénieurs ont pris quelques phrases extraites d’une interview donnée par Xavier Niel, et lui font tenir un court discours sur l’IA qu’il aurait très bien pu prononcer. Le clonage est parfait : la tessiture, l’intonation légèrement gouailleuse, rien ne manque. Assis au premier rang, le patron de Free est rayonnant. Au contraire des présentations scénographiées des Gafam, aucune vidéo n’a été préenregistrée : un simple MacBook est connecté au modèle qui tourne quelque part sur l’un des serveurs de Scaleway, la filiale cloud du groupe Iliad. Tout fonctionne sans accroc. Certes, le prototype est imparfait. C’est Neil Zeghidour, cofondateur du lab et responsable de l’élaboration des modèles, qui bombarde Moshi de questions. L’assistant vocal est tellement réactif qu’il tend à couper la parole à son interlocuteur. Il semble aussi carburer au Guronsan tant il parle vite. C’est la rançon d’une performance dont les ingénieurs et scientifiques de Kyutai ne sont pas peu fiers.

Moshi est capable de faire la distinction entre une simple approbation – un « hmm-hmm » – et une relance conversationnelle.

Le temps de latence – le délai pendant lequel une interface vocale semble réfléchir – est habituellement l’obstacle principal à une conversation fluide. Là où ChatGPT version 4 met plusieurs secondes à générer la réponse et à la restituer vocalement, Moshi prend moins de 0,2 seconde. « C’est un problème extrêmement complexe à résoudre », explique Zeghidour, qui est à 34 ans l’un des meilleurs spécialistes au monde du traitement audio, selon ses collègues. Habituellement, les interfaces débitent leur réponse sans qu’on puisse les interrompre, les relancer ou réorienter la discussion. Moshi, lui, est ce qu’on appelle full duplex : l’algorithme est capable de faire la distinction entre une simple approbation – un « hmm-hmm », un « OK » – et une relance conversationnelle. Il agit en conséquence, soit en l’ignorant, soit en adaptant à la volée sa réponse. Dans la salle, les deux cents invités applaudissent la répartie de l’appli.

C’est au tour d’Edouard Grave de prendre la parole. Son CV aligne les meilleures formations en sciences informatiques : le MIT à Boston, trois années à l’Inria (Institut national de recherche en sciences et technologies du numérique), des passages par les universités de Berkeley et Columbia, sept ans chez Facebook. Chez Kyutai, il est chargé de la construction du modèle de langage qui est au cœur de Moshi. Helium 7B est un LLM ultra-compact : 7 milliards de paramètres – deux cents fois moins que les stars du marché comme GPT-4 d’OpenAI ou Gemini Ultra de Google. Il peut être embarqué dans un téléphone portable – le vecteur naturel des interfaces audio. Les chercheurs de Kyutai sont convaincus, comme d’autres, que les agents conversationnels seront le principal mode d’interaction avec les IA d’ici quelques années.

La présentation est à peine terminée que, sur son portable, le DRH Guillaume Rouzaud voit affluer les CV. « J’en ai eu 150 dans les dix jours qui ont suivi », confiera-t-il plus tard. Côté recrutement, Kyutai a des problèmes de riche. « Dès la création de la fondation, nous avons reçu plus de candidatures que nous l’avions anticipé, constate Patrick Pérez. Nous avons dû faire une sélection drastique. » Et encore le PDG a-t-il écarté les prétendants résidant à l’étranger ; pas question de travailler à distance, en tout cas pas de façon systématique. Les huit ingénieurs qui ont été retenus sont issus des grandes écoles scientifiques françaises et sont pour la plupart passés par les centres de recherche des Gafam : Microsoft Research pour Patrick Pérez, Google Brain et Google DeepMind pour Neil Zeghidour, Facebook Artificial Intelligence Research (FAIR) pour Laurent Mazaré, Hervé Jégou, Alexandre Défossez, ou Edouard Grave, qui sont quelques-uns des piliers du lab.

Contre l’hégémonie américaine

L’aventure de Kyutai commence début 2023. C’est Nicolas Granatino, un investisseur français résidant à Londres, qui joue le rôle d’entremetteur essentiel dans l’affaire. Polytechnicien de formation, il a également étudié la biologie à Oxford. Ses activités sont aussi diverses que l’homme est vibrionnant et enthousiaste. Élégant, charmeur, il est toujours en transit entre Londres, Paris, New York et la Silicon Valley – où réside son ami Eric Schmidt –, jonglant entre son fonds d’investissement, Andurance Ventures, et diverses start-up qu’il conseille.

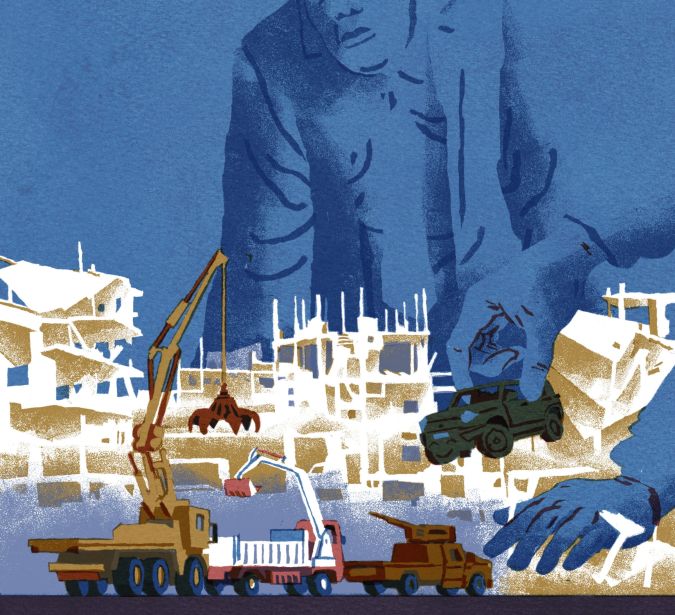

Toujours bien informé, il entend dire, un beau jour, que le patron d’Iliad envisage la création d’une fondation dans le domaine de l’intelligence artificielle, à Paris. Xavier Niel n’a jamais caché son irritation devant l’écrasante domination technologique et culturelle des États-Unis sur l’IA. Il répète à tous ses interlocuteurs qu’il ne veut pas d’un système contrôlé par des algorithmes made in USA avec des modèles surpuissants, entraînés sur des tombereaux de données anglophones, porteurs de biais culturels et sociétaux.

La tech française est majoritairement sur la même longueur d’onde que lui. Certains invoquent des questions de performances – si on crée une IA d’enseignement, il est préférable qu’elle repose sur des pratiques et des valeurs éducatives françaises. Pour d’autres, les considérations sont plus souverainistes avec, en filigrane, une solide aversion pour les Gafam.

OpenAI parti en pôle position

Le 27 février 2023, Nicolas Granatino découvre la grande nouvelle du jour : trois mois après le séisme provoqué par OpenAI et son modèle grand public GPT-3, Meta lance le sien, baptisé LLaMA. Et, à la surprise générale, l’ex-Facebook annonce que son architecture, ses paramètres et l’origine de ses données seront en accès libre. Mieux, LLaMA sera publié en quatre versions allant de 7 à 65 milliards de paramètres, ce qui permet une large variété d’usages. Il fait en outre l’objet d’un papier scientifique qui détaille la structure et les choix techniques. C’est un peu comme si Chanel offrait à qui veut les gabarits de découpe, les spécifications et le mode d’assemblage de sa gamme. La démarche stupéfie le monde de l’IA.

Car depuis l’automne précédent, entre les géants de la tech et un petit groupe de nouveaux venus, c’est à qui lancera le modèle de langage le plus puissant. Avec son ChatGPT, OpenAI a ouvert les hostilités en 2022, prenant la tête de la course avec un million d’utilisateurs en cinq jours – 200 millions, en août 2024. Pris de panique, Google a tenté une riposte en janvier 2023, mais une démonstration bâclée a porté un sérieux coup à sa réputation. Quelques mois plus tard, Microsoft a fait les frais d’un LLM sorti trop vite et mis en lumière les risques des IA génératives dont le comportement est souvent erratique ; en un bel anthropomorphisme, les spécialistes parlent d’« hallucination » pour évoquer la propension des LLM à raconter n’importe quoi.

Parti en quatrième position, Meta se rattrape donc début 2023 avec son LLaMA qui, dans les tests de performance, surpasse GPT-3 d’OpenAI, pourtant dix fois plus gros, et fait jeu égal avec PaLM, le modèle star de Google, quarante fois plus complexe. « Je réalise alors que les auteurs de l’article académique sur LLaMA sont quasiment tous français, s’amuse Nicolas Granatino. Sur les quatorze chercheurs qui ont signé le papier, neuf sont passés par l’X [Polytechnique, NDLR] et deux par l’ENS. Tous sont à Paris et travaillent chez FAIR, le laboratoire de Meta ! »

Depuis ses bureaux de Londres, il en contacte trois. Le premier à répondre est Gautier Izacard, qui termine son doctorat à l’École normale tout en travaillant au laboratoire de Facebook. Celui-ci livre une information importante : plusieurs ingénieurs de FAIR sont en contact avec Aude Durand, une X passée par Stanford, numéro deux d’Iliad et surtout présidente de Scaleway, la filiale infrastructure d’Iliad. C’est elle qui est aux commandes du projet de fondation-laboratoire française porté par Xavier Niel.

La jeune femme agite tous ses réseaux. Elle contacte quelques-uns de ses condisciples de Stanford, qui a produit le plus grand nombre de fondateurs de licornes, ces start-up valorisées à plus d’un milliard de dollars ou d’euros. L’université californienne est la voie royale pour de jeunes ingénieurs français qui viennent y parfaire leur cursus. Elle fait aussi partie intégrante de l’écosystème d’une Silicon Valley noyée sous un flot de financements ; les valorisations de start-up explosent, offrant aux jeunes diplômés en sciences informatiques des perspectives et des salaires impensables en France. Aude Durand comprend qu’il vaut mieux se concentrer sur des recrutements à Paris, où le gisement de compétences est riche.

Kyutai est un ovni. Le laboratoire balaie tous les codes du secteur et en a fait un argument de recrutement.

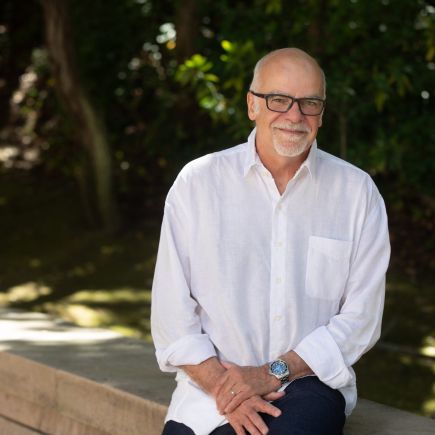

Kyutai est un ovni dans le monde de la tech. Le laboratoire balaie tous les codes du secteur et en a fait un argument de recrutement. « Leurs motivations pour venir chez nous ? La petite taille de l’équipe, la liberté sur les axes de recherche, le choix de l’open source et la connexion au monde académique », explique le PDG, Patrick Pérez. Il est le senior de la bande – 55 ans, pour une moyenne d’âge de 37 ans. Avec son physique de marathonien et sa voix douce, il n’a rien de l’arrogance des directeurs de start-up ; il tire sa légitimité de son parcours et de sa notoriété universitaire. Pur produit de la recherche française, Pérez est passé par la faculté de Rennes, l’École centrale et l’Inria, l’équivalent du CNRS dans la recherche informatique. Sa spécialité reconnue internationalement dans le traitement d’images – ce qu’on appelle la computer vision – lui a valu de travailler, entre autres, pour Microsoft Research et l’équipementier automobile Valeo, dont il a créé le laboratoire d’intelligence artificielle.

« La référence absolue des gens qui sont ici, c’est Google Scholar et GitHub », résume Guillaume Rouzaud, évoquant la grande base d’articles scientifiques de Google et la bibliothèque qui rassemble tous les logiciels et algorithmes mis dans le domaine public. « Ils veulent contribuer à la science par leurs publications, effectuer des travaux qui auront un impact durable sur le secteur et sur les usages de l’IA… » Chez Kyutai, certains ont même refusé d’aller travailler dans des entreprises offrant un service d’optimisation fiscale à leurs cadres. Une posture raccord avec les préférences politiques d’une équipe qui penche vers la gauche. « Si on regarde les sites internet qu’ils visitent parfois, disons que le spectre va de la chaîne YouTube de “Blast” [vidéos d’information tendance Mediapart, NDLR] au “Monde” », sourit l’un d’eux.

Le kolkhoze de l’open source

« Les gens viennent pour l’opportunité de travailler sans contrainte commerciale et de pouvoir publier le résultat de leurs recherches, analyse Neil Zeghidour, depuis un restaurant de la rue Rambuteau, dans le centre de Paris. Cette liberté et cet accès à la reconnaissance des pairs est ce qui attire les talents chez nous. » Mais pas uniquement. « Plus que du salaire, les candidats s’inquiètent des sujets de recherche, de leur accès à des capacités de calcul, de combien de processeurs H100 nous disposons », confie Guillaume Rouzaud. Le H100, c’est la Ferrari des microprocesseurs dédiés à l’élaboration des LLM, fabriqués par le géant californien Nvidia.

Ici, les réunions sont réduites au minimum et durent peu. La petite cuisine qui jouxte la salle commune est un lieu d’échange aussi prisé que l’unique grande salle du premier étage. Par comparaison avec une entreprise classique, le fonctionnement de Kyutai relève plutôt du kolkhoze. L’homogénéité du recrutement fait que chacun est soucieux de la collectivité. « Le système s’autorégule. Pas besoin de faire la police, même si personne ne perd de vue que Patrick est le patron », juge le DRH.

Une compétition purement technique

Parmi les auteurs du fameux papier de Meta figure un autre chercheur de talent. Après sept ans passés chez Facebook AI, le polytechnicien Guillaume Lample est tenté par une aventure entrepreneuriale. Avec un autre Français, Arthur Mensch, employé par Google DeepMind depuis deux ans, ils travaillent à la création de Mistral AI, qui va devenir l’icône de l’IA en France. La pure start-up, gavée de financements – 1,1 milliard d’euros – et employant 60 personnes, joue aussi la corde de l’open source avec des modèles en accès libre qui lui assurent sa notoriété. Mais elle espère vivre avec des LLM plus puissants pour les grandes entreprises qui, eux, sont payants. Guillaume Lample a donc choisi Mistral, que les gens de Kyutai évoquent en parlant de leurs « concurrents », même si la compétition est purement technique : chacun regarde ce que fait l’autre, structure des modèles, architecture, nombre de paramètres…

Nicolas Granatino suit de près la création de Mistral AI pour la bonne raison qu’il y a fait entrer, avec un ticket modeste, Eric Schmidt, Rodolphe Saadé et Xavier Niel. Le 1er mai 2023, il envoie un e-mail au patron de Free : « Je sais que tu envisages un projet de mécénat dans l’IA. Eric aussi. Il faut qu’on en parle. » Niel renvoie Granatino vers la patronne de Scaleway.

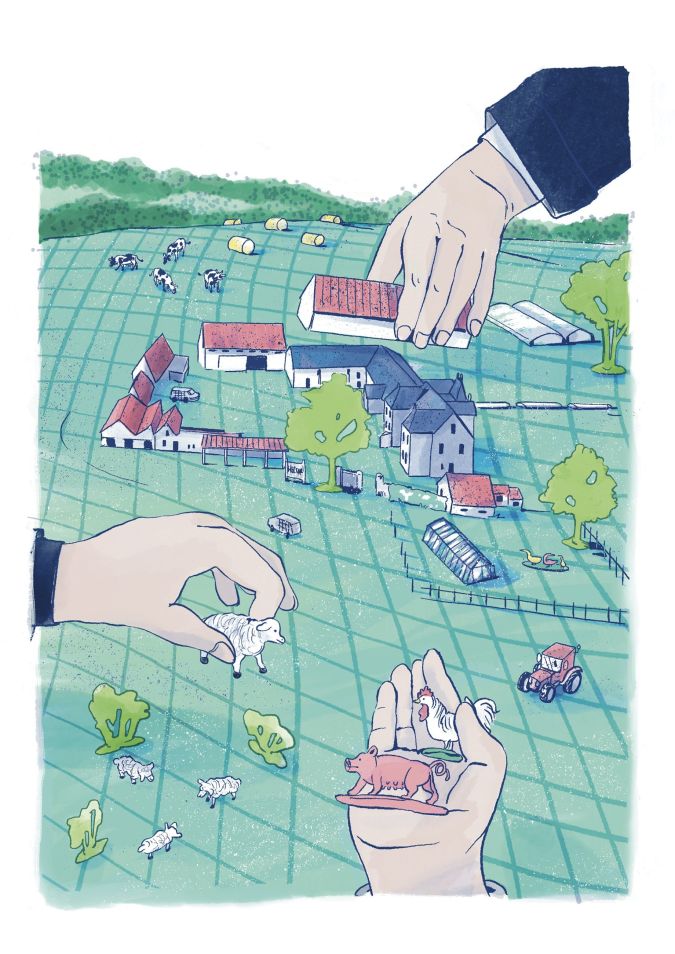

Niel et Saadé finançant une fondation scientifique, c’est comme un duo de requins qui deviendraient végans.

Fait qui a son importance, Aude Durand vient de passer commande de 1 000 microprocesseurs dédiés à l’entraînement des modèles d’IA, un investissement d’une trentaine de millions d’euros qui fait d’Iliad l’un des plus gros clients de Nvidia en Europe – une seconde commande du même ordre a été passée au printemps 2024. Cet élément répond à la première condition posée par Eric Schmidt. L’ancien patron de Google ne veut pas s’engager dans le projet Kyutai sans un minimum d’infrastructure : sans puissance de calcul, pas de modèles puissants ni de capacité à attirer les talents. Sa seconde exigence est une garantie que la structure sera bien à but non lucratif, et le restera. Niel, via Granatino, en prend l’engagement. Les deux hommes veulent éviter le piège OpenAI. Pensée comme un laboratoire où tout serait en open source, l’entreprise qui a inventé ChatGPT a cédé à une stratégie de domination absolue sur l’IA nécessitant des investissements colossaux.

Niel et Saadé finançant une fondation scientifique, c’est comme un duo de requins qui deviendraient végans. Ils peuvent se le permettre : Forbes estime la fortune de Niel à 10 milliards de dollars et celle de Saadé à 9 milliards. Leur groupe n’étant pas coté en bourse, ils font ce qu’ils veulent de leurs profits. Le cas de Schmidt est différent. Avec 21,7 milliards d’actifs personnels selon le palmarès 2024 de Forbes, il s’inscrit dans la lignée des grands patrons américains qui, immense fortune faite, se lancent dans le mécénat à grande échelle. Pour cela, il a créé Schmidt Futures, élément central d’un réseau de fondations couvrant la recherche en sciences informatiques, la biologie synthétique, l’éducation et même le secteur de la défense. Pour ces trois-là, l’investissement dans Kyutai représente moins d’un pour cent de leur fortune consolidée, même si, comme Xavier Niel le remarque en privé : « Cet argent, on fait une croix dessus, on ne le reverra jamais. »

Investissements rentables

Pour lapidaire que soit la formule, elle devra se vérifier sur le long terme. Quand on lui pose la question, Xavier Niel se montre catégorique : il n’y aura pas d’extension business de Kyutai, ni sous forme de propriété intellectuelle ni sous forme de produits commerciaux. Maintenant, regardons en face la réalité financière et industrielle. Il serait logique qu’une grande partie de l’apport d’Iliad se fasse en nature, à savoir par l’accès aux capacités de calcul conférées par le stock de microprocesseurs Nvidia H100. C’est une pratique courante dans la tech. Le coût est donc moindre pour l’investisseur. Par ailleurs, en France comme aux États-Unis, les investissements dans des fondations sont défiscalisables. Enfin, sur le plan industriel, Iliad et CMA CGM optimisent leur activité grâce à l’IA : gestion des réseaux de données pour le premier et rationalisation d’une myriade de flux pour le second, allant du remplissage des navires aux calculs des routes les plus efficientes, en passant par la maintenance des bateaux. CMA CGM n’est guère prolixe sur son recours à l’intelligence artificielle, mais c’est un département essentiel chez son concurrent Maersk, le numéro un du fret, qui a recruté une équipe de haut niveau pour le gérer.

Dans l’immédiat et dans son aile de l’hôtel particulier du Marais, l’équipe se concentre sur la production de l’article scientifique sur Moshi et sur la mise en open source des composantes du système. L’appli audio est encore brouillonne, mais se fait déjà remarquer dans l’univers extraordinairement compétitif de l’IA alors que la fondation n’a pas un an. En bonne logique, chercheurs et entrepreneurs du monde entier devraient s’en emparer, l’améliorer, construire des services et même des produits : un LLM audio qui tient dans la mémoire d’un téléphone portable, c’est tentant pour une start-up et des investisseurs en quête de la prochaine pépite. Moshi n’a coûté que 10 millions d’euros, contre plusieurs centaines de millions pour les stars du secteur développées par OpenAI, Google ou Facebook. Par la suite, le laboratoire compte poursuivre ses travaux dans l’IA dite multimodale : combinaison de texte, son, image et vidéo. Les projets restent secrets.

Kyutai va aussi devoir gérer sa croissance. Pour l’heure, l’augmentation de ses effectifs est contrainte par ses capacités de calcul et aussi par la difficulté à attirer les meilleurs jeunes chercheurs, encore aimantés par la prodigalité des Gafam. Et puis, il y a des questions plus fondamentales. Il n’est pas sûr que les grands modèles de langage soient l’avenir de l’IA. Ils sont instables, souvent dangereux, gourmands en énergie. Les scientifiques divergent sur leur potentiel et leurs limites. Yann Le Cun, chercheur star de l’IA, employé par Meta, siège au conseil scientifique de Kyutai. Or, il ne cesse de pourfendre les LLM, incapables, selon lui, de raisonner et de planifier. Ce qui rend plus illusoire le graal de l’intelligence artificielle dite générale, censée se rapprocher des capacités humaines.