Teven Le Scao se souvient encore de cette nuit blanche dans une coloc exiguë, et de ce premier projet qui a changé sa vie. Il est à peu près « mille heures du matin » à New York. Au bout du marathon, après des mois de calcul et de programmation avec une équipe aux quatre coins du monde, le jeune polytechnicien français appuie sur le bouton « entrée » de son ordinateur portable. Quelques millisecondes plus tard, le signal emprunte les câbles sous-marins de l’Atlantique et parvient jusqu’à une salle des machines du plateau de Saclay, au sud de Paris. Le Jean-Zay, plus grand ordinateur de France, se met en branle. Quatre cents cartes graphiques de type A100, achetées à l’entreprise américaine Nvidia, tournent jusqu’à la surchauffe sous le regard inquiet des techniciens.

Ainsi débutait, en mars 2022, l’entraînement de Bloom, le LLM made in France. Les LLM, ce sont les « grands modèles de langage » ou « grands modèles de langue », ces mastodontes de prédiction statistique qui, avec un entraînement suffisant, deviennent capables de prouesses d’expression. À même pas 30 ans aujourd’hui, Teven Le Scao a participé à la conception d’un autre depuis, plus connu : Mistral 7B, dont les remarquables performances ont fait tomber une pluie d’or sur la start-up française Mistral AI, valorisée à 12 milliards d’euros fin 2025, en à peine trois ans d’existence.

Un séisme scientifique

Mais construire un LLM est un savoir qui, à l’époque, n’est donné qu’à une poignée de scientifiques pionniers : ceux qui ont mis au monde GPT3 en octobre 2020, le modèle dont sera tiré en novembre 2022 l’agent conversationnel ChatGPT. Ses inventeurs ont déjà partagé au monde ce modèle impressionnant, mais pas du tout ses secrets de fabrication. C’est donc pour créer son propre modèle, Bloom, qu’est né en France un collectif étrange et défricheur. Lancé la fleur au fusil, avec un fonctionnement collaboratif, il est ouvert à qui veut bien s’y joindre et partager tous ses résultats.

Il n’est pas anodin que cette histoire commence au 5, parvis Alan-Turing, dans le 13e arrondissement de Paris. La place baptisée d’après le père de l’informatique abrite la Station F, gigantesque incubateur de start-up françaises. Fin 2020, quelque part entre deux confinements, Thomas Wolf s’agite. Ce trentenaire a le curieux CV de ceux qui ne peuvent pas rester en place. Un polytechnicien qui a fait une thèse de mécanique quantique avant de travailler six ans dans un cabinet d’avocats. Puis d’en claquer la porte en 2017 pour sauter dans le train du machine learning, l’apprentissage automatique.

Thomas Wolf a cofondé Hugging Face, une plateforme de développement d’outils d’intelligence artificielle (IA) utilisée quotidiennement par les chercheurs du monde entier lorsqu’ils veulent partager leur travail et héberger des projets. Depuis le séisme scientifique GPT3, il ne rêve que d’embarquer ses ingénieurs, dont Teven Le Scao fait alors partie, dans un projet de LLM. Mais il lui manque un élément crucial : la puissance computationnelle. L’entraînement d’un LLM requiert l’utilisation concertée de centaines, sinon de milliers, de cartes graphiques pendant plusieurs mois. Les lieux qui disposent de telles infrastructures, chez Meta (Facebook), OpenAI (ChatGPT), Google, ou à l’université de Stanford, se comptent sur les doigts d’une main.

Ministre du Front populaire

L’homme avec qui Thomas Wolf a rendez-vous ce jour-là détient les clés de l’un de ces temples de l’informatique. Stéphane Requena est un homme affable et un excellent pédagogue. Il est le CTO – directeur technique – du Genci, le Grand Équipement national du calcul intensif. Cette agence publique a pour mission de mettre à disposition de qui veut, institution académique ou entreprise, des moyens de calcul informatique XXL. Le Genci a acquis en 2019 le superordinateur Jean-Zay.

Quand Stéphane Requena en parle, sa voix s’embrase – « c’est un accélérateur de science ». Une fenêtre sur l’univers par le calcul haute performance, grâce auquel les scientifiques peuvent exécuter des simulations sur l’évolution de la matière noire ou la collision des galaxies. Mais, en 2020, l’ordinateur public français doit ajouter à ses occupations cosmiques une activité qui commence à faire parler d’elle : l’entraînement de l’intelligence artificielle. L’ordre vient d’en haut. Le président Emmanuel Macron a lancé son plan AI for Humanity (« IA pour l’humanité ») en 2018, et les consignes sont dûment relayées.

À la suite de leur entrevue, Thomas Wolf et Stéphane Requena échafaudent le projet que portera Hugging Face. L’alliance est scellée entre la start-up nation et le superordinateur baptisé du nom d’un ministre socialiste du Front populaire. Quelques mois de lobbying plus tard, après avoir convaincu les trois grands labos publics français travaillant sur l’IA – le Limsi de l’université Paris-Saclay, l’Almanach de l’Inria et le Loria de l’université de Lorraine –, l’assemblage reçoit le feu vert du coordinateur national pour l’IA, Nicolas Amar. Nom du projet : BigScience.

Une tour de Babel dont les étages seraient des fils de conversation Slack.

Le groupe de recherche public-privé décroche le graal qui, en intelligence artificielle, s’exprime en durée : 5 millions d’heures de calcul sur Jean-Zay, ce qui correspond à un coût d’à peu près 2 millions d’euros. Ce montant peut paraître dérisoire, quand les investissements actuels se comptent en dizaines de milliards de dollars aux États-Unis. Mais à l’époque, le coût d’entraînement de ChatGPT avait été estimé à un montant d’environ 4,5 millions de dollars.

Alors que le calcul haute performance est si rare, le mot circule. 5 millions d’heures, ouvertes à tous ! Depuis les États-Unis mais aussi l’Inde, l’Allemagne ou l’Indonésie, des chercheurs s’insèrent dans les groupes de travail pour défricher les contours de ce nouveau monde. BigScience devient rapidement une sorte de tour de Babel dont les étages seraient des fils de conversation Slack et des entrées dans un Google Doc.

Qui ne veut pas s’approcher du garage grand ouvert dans lequel on apprend à construire la voiture du futur ? Au total, ils sont près d’un millier de scientifiques à toquer à la porte, à des degrés très divers d’engagement. Le téléphone de Thomas Wolf ne cesse de sonner, sa boîte mail est inondée de conversations estampillées BigScience. Un projet œcuménique se met en branle.

Violence et discriminations

« Le fait d’avoir eu une approche très ouverte nous a attiré beaucoup de sympathies, explique rétrospectivement Teven Le Scao. Le milieu scientifique était très attaché à l’ouverture et au partage des découvertes, or OpenAI [avec GPT3] avait un peu violé cette norme morale. » Et le refus de partager en open source n’est pas la seule « norme morale » mise en péril. Dans l’ombre des premiers développements stupéfiants de l’intelligence artificielle générative, certains en voient immédiatement les dangers : manipulation des utilisateurs, incitation à la violence, reproduction des discriminations…

En décembre 2020 et février 2021, Google licencie coup sur coup deux de ses chercheuses devenues trop remuantes, Timnit Gebru et Margaret Mitchell, qui travaillaient sur les risques que posaient les LLM. Margaret Mitchell est débauchée par Hugging Face qui, avec BigScience, revendique de faire les choses autrement.

De fait, dans les réunions, les scientifiques s’écharpent pendant des heures sur les données qu’il faut retenir et celles qu’il faut écarter. Un principe de bon sens, promu par les ingénieurs responsables de l’architecture du modèle, serait par exemple de ne rien garder qui renvoie de trop près à la sexualité, pour éviter que le modèle ne régurgite ensuite des propos interdits aux mineurs. Sauf que, observent d’autres chercheurs de BigScience, écarter à l’échelle industrielle ces références risque de faire disparaître au passage toute une palette de mentions à la diversité des identités et des pratiques, ce qui risquerait de rendre le modèle trop hétéronormé.

Coloration américaine

« Il y avait quelque chose de très innovant dans la façon dont étaient formulés les problèmes », se souvient Ellie Pavlick, chercheuse à Brown University. L’Américaine travaille à l’époque chez DeepMind, la puissante entité de Google dévolue à l’intelligence artificielle. Elle parvient à convaincre sa hiérarchie de la laisser s’investir dans Bloom et devient responsable du groupe chargé de l’évaluation du modèle à venir. Angela Fan, une jeune prodige du laboratoire parisien de recherche en IA de Meta, à qui l’on ne refuse rien dans l’entreprise de Mark Zuckerberg, se met aussi au travail dans les ateliers de BigScience.

Mais cette coloration américaine n’est pas au goût de tout le monde. Plusieurs chercheurs français des laboratoires publics l’admettent aujourd’hui : ils ne savaient pas, au moment où ils ont donné leur assentiment au projet de Thomas Wolf, que son entreprise, Hugging Face Inc., était enregistrée dans l’État américain du Delaware – malgré sa forte implantation à Paris et la nationalité française de ses trois fondateurs.

Dans la répartition des tâches et des activités, les chercheurs du monde académique français nouent certes de précieuses collaborations. Mais ils se disent parfois, rétrospectivement, qu’ils ont servi de caution française publique à un projet qui, au fil du temps, l’a été de moins en moins. « La demande d’allocation de temps de calcul par Jean-Zay n’a été possible que parce que la communauté académique française s’est mobilisée », se souvient Aurélie Névéol, directrice de recherche en informatique au CNRS. À BigScience, elle a travaillé d’arrache-pied sur l’évaluation de Bloom, pour qu’il soit possible de jauger son impact environnemental comme l’éthique de ses jeux de données. « Après, on a été noyés, sinon dépossédés, par une communauté internationale plus large qui n’était pas prévue au départ. Le networking a tourné à plein régime pour le privé, moins pour nous. »

Révolution scientifique : personne ne comprend rien, c’est le chaos absolu. Et c’est un bonheur.

Julien Launay, doctorant à l’époque de BigScience

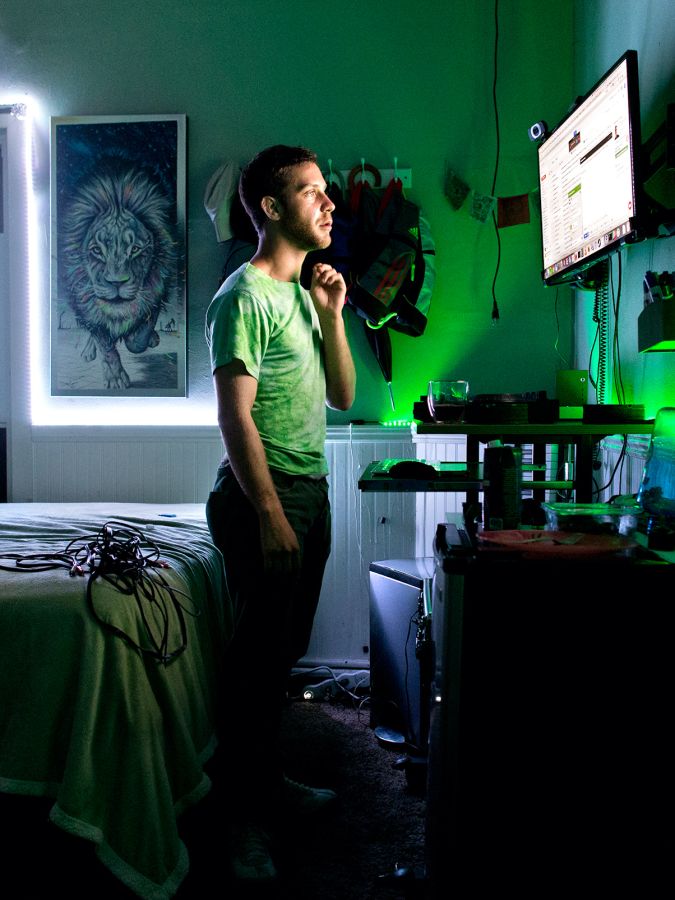

Julien Launay est l’un des premiers jeunes chercheurs français à avoir rejoint Teven Le Scao. Appelé par Thomas Wolf, ce doctorant chez la start-up française LightOn, cheveux frisés et lunettes rondes, se jette dans le projet à corps perdu avec le reste de son équipe. Jamais il n’aurait pu rêver d’autant d’heures de calcul. À BigScience, avec Teven Le Scao et une poignée d’autres jeunes, ils se retrouvent à collaborer avec des pointures mondiales.

Comme des gosses dans un magasin de jouets, ils apprennent le fonctionnement d’outils de pointe en matière d’apprentissage profond, comme DeepSpeed, directement guidés par les équipes de son développeur, Microsoft. Pour qu’ils testent leurs idées, Google DeepMind leur ouvre les portes de ses serveurs en grand. « On a eu accès en alpha au nouveau TPU v4 de Google, se réjouit Julien Launay comme si son interlocuteur y comprenait quoi que ce soit. À l’époque, c’était open bar ! J’ai halluciné de la quantité de ressources qu’il y avait. »

Un mot anglais revient souvent chez le jeune chercheur pour décrire l’ambiance qui régnait au sein de BigScience : « evergreen ». Ce qui signifie : une nature encore inexplorée, dans laquelle il faut avancer à tâtons. « En LLM, reprend-il, on dispose de très peu de théorie, alors il faut faire plein d’expériences. On testait tout. Nous étions exactement dans ce qu’entendait le philosophe Thomas Kuhn par “révolution scientifique” : plus personne ne comprend rien, c’est le chaos absolu. C’est très rare dans l’histoire. Et c’est un bonheur. »

« Trop hippie »

Et puis, le chaos a accumulé du retard. Faire un LLM est une chorégraphie très séquencée. Il faut d’abord trouver des données, les nettoyer, les mettre dans un modèle, l’entraîner. Impossible d’avancer tant que les autres étapes ne sont pas terminées. Sauf que les pièces de la fusée n’arrivent pas à temps. Les rêves de performance des jeunes talents chargés de la programmation ne s’accommodent pas toujours bien des réflexions de fond sur l’éthique des jeux de données. Tout le monde ne goûte pas l’hubris d’avoir voulu un modèle gargantuesque de 176 milliards de paramètres, c’est-à-dire un milliard de plus que GPT3, juste pour faire mieux qu’OpenAI. Chacun travaille à son rythme, dans une organisation horizontale et volontaire qui commence à faire sentir ses limites.

« Dans les réunions de travail, les idées discutées étaient avant-gardistes, raconte Ellie Pavlick, la chercheuse de Google DeepMind. Mais, en bout de chaîne, ce que l’on était en mesure de livrer était sous les standards. » L’Américaine met des mots sur un sentiment partagé : BigScience était « trop hippie » pour être performant. Le mythe de la communauté s’arrête, alors que l’entraînement sur Jean-Zay doit commencer et que les équipes ne sont pas prêtes. Thomas Wolf se résout à détacher une dizaine d’employés de son entreprise Hugging Face à temps plein pour honorer l’échéance.

Les doutes du grand frère

« On s’est lancés dans ce modèle un peu trop pharaonique, la fleur au fusil », ressasse-t-il. Barbe de trois jours, blond bronzé aux yeux verts, le fondateur de Hugging Face – aujourd’hui valorisée à 4,5 milliards de dollars – est assis devant sa bibliothèque. Les appels s’enchaînent, créneaux de quinze minutes ou de trente selon l’interlocuteur, réglés par le métronome de l’appli à la mode, Calendly. Il est presque un ancien, dans ce milieu où tout va si vite. À 40 ans et déjà quelques mèches grises, il a quelque chose d’un parrain ou d’un grand frère pour l’IA française.

Thomas Wolf a vu passer et a soutenu, comme business angel, les applications les plus prometteuses de l’intelligence artificielle générative from France. Mistral AI bien sûr, mais aussi Kyutai pour son assistant vocal ou Bioptimus pour la recherche médicale. Après la publication finale de Bloom, le modèle dont il est à l’origine et qu’il a porté à bout de bras, il s’est souvent posé une question : est-ce que ça en valait vraiment le coup ? « On a voulu faire trop gros et, finalement, le modèle n’est pas à la hauteur. »

Pour les « fils et filles de BigScience », comme les appelle Stéphane Requena, les jeunes ingénieurs qui y ont fait leurs armes, la réponse est oui – ça en valait la peine. Juste après la fin de l’aventure, Julien Launay est approché par le Technology Innovation Institute, le centre de recherche en intelligence artificielle d’Abou Dhabi. Son expérience dans l’édification d’un LLM open source, à plus forte raison qui inclut la langue arabe, en fait une recrue en or pour satisfaire l’ambition des Émirats arabes unis d’avoir leur propre modèle. Launay s’installe à Abou Dhabi et devient responsable technique de l’équipe qui accouchera du LLM Falcon. La course mondiale a déjà changé de dimension, et dix fois plus de cartes graphiques sont mobilisées pour l’entraînement. C’est, à sa sortie, le plus gros modèle open source au monde – qui sera utilisé par deux géants de la tech, ByteDance (TikTok) et LinkedIn.

« Ils vont faire beaucoup d’argent »

De l’autre côté de l’Atlantique, un certain Arthur Mensch a observé avec intérêt les évolutions de BigScience. Ingénieur discret chez Google DeepMind, le jeune Français réalise dès cette époque que l’entraînement du modèle du plateau de Saclay sera sous-optimal. Avec ses compères de Google, ils sont sur le point de publier un article décisif, intitulé Chinchilla Scaling Laws, qui propose une loi s’appuyant sur le rapport entre la taille d’un modèle et la quantité de données nécessaires. À l’époque, les scientifiques de BigScience l’ignorent et, fatalement, l’enfreignent. Le modèle est trop gros par rapport à la taille des jeux de données, ce qui pose des problèmes de performance.

Mais Arthur Mensch note les noms. Il se prépare à rentrer en France et a besoin de jeunes talents. Lors de l’entretien d’embauche de Teven Le Scao pour devenir l’un des premiers soldats de sa brigade Mistral AI, il n’est presque question que de son travail pour forger le LLM de BigScience, Bloom. Quelques mois plus tard, la mini-équipe qui développe Mistral 7B compte trois anciens du projet dans ses rangs.

De retour des Émirats, Julien Launay fonde de son côté en octobre 2023, avec un chercheur suédois qui travaillait à ses côtés sur BigScience, une start-up appelée Adaptive ML. En un an, les deux scientifiques devenus entrepreneurs lèvent 20 millions d’euros. Ils vendent de l’IA bien sûr, mais plus précisément une méthode qui offre aux entreprises la possibilité de former leur modèle en continu, grâce à l’apprentissage par renforcement. « Ils vont faire beaucoup d’argent avec ça », souffle un ingénieur bien informé d’une entreprise concurrente. Adaptive ML, qui opère principalement aux États-Unis, vient d’y décrocher un contrat avec AT&T, le titan des télécoms.

La fin d’un monde et le début d’un autre

BigScience avait voulu proposer un autre modèle. Une autre façon de construire des LLM. Non-commerciale. Horizontale. La main dans la main avec les laboratoires publics. Dans une logique de partage et d’exploration scientifique. Grâce aux modiques 2 millions d’euros d’heures de calcul fournies par les pouvoirs publics français, BigScience a certes réussi à accoucher d’un LLM multilingue, qui rédige des poèmes et des dissertations, parle arabe, français et yoruba.

Mais, paradoxalement, il a acté la fin d’un monde et le début d’un autre, celui des start-up et de la course à la performance. « Tout ce qu’on a fait avec Bloom, on ne pourrait plus le faire aujourd’hui, confirme Julien Launay. Désormais, c’est avec les LLM que DeepMind ou Mistral vont faire le gros de leur argent. » La monétisation des grands modèles de langage, vendus sous forme de chatbot, de rédacteur, d’assistant aux entreprises soucieuses de ne pas rater le train en marche, est devenue une affaire de milliards d’euros. « À l’époque, un LLM, c’était excitant scientifiquement. Aujourd’hui, c’est un produit commercial », reconnaît le fondateur d’Adaptive ML.

L’organisation du travail est devenue industrielle, millimétrée, verticale. Secrète aussi. Les entreprises d’IA se font désormais la course pour conquérir des marchés. Loin de l’ouverture et du partage des connaissances de BigScience, une ambiance paranoïaque s’est installée dans les bureaux parisiens des start-up d’IA, entre caméras biométriques et peur de l’espionnage industriel. Alors, si Teven Le Scao s’est montré très prolixe sur ses années BigScience, de son présent chez Mistral, il ne dira rien.