Légende photo ci-dessus

« Cette version IA du tableau de Vermeer La Jeune Fille à la perle a été réalisée par le créateur numérique berlinois Julian van Dieken, dans le cadre du concours “Ma fille à la perle” organisé par le musée Mauritshuis de La Haye. » (Photo : Simon Wohlfahrt / AFP)

« Bing, bing, bing. » Tout en onomatopée, Gilles Courtinat imite le flot continu de photos qui défilent sur son écran. Rédacteur pour le média consacré à la photographie de presse « L’Œil de l’info », le journaliste passe un temps considérable à observer les créations de Midjourney, une intelligence artificielle (IA) capable d’exercer – presque – tous nos vœux. Il suffit de lui en faire la demande sur la page d’un forum dédié. En quelques secondes, le logiciel fabrique une image qu’il publie à la vue de tous. Une mine d’or pour ce passionné de nouvelles technologies et de photographie.

Gamin, Gilles Courtinat voulait dessiner. Puis il découvre la photographie, à laquelle il s’essaie, avant de comprendre « [qu’il n’est] pas le nouveau talent que tout le monde attend ». Il passe alors « de l’autre côté du miroir avec celles et ceux qui permettent aux photographes d’exprimer leur talent et d’en vivre ». Au gré de ses expériences de directeur d’achat d’art dans la publicité, de chef de services photo, d’iconographe pour Libération ou en free-lance, Gilles Courtinat a aiguisé son regard sur la création visuelle.

Quand, en 2021, des logiciels se mettent à fabriquer des clichés plus vrais que nature, il sent immédiatement « que quelque chose d’important est en train de se passer ». Certaines créations, amusantes, montrent le pape François au guidon d’une Harley Davidson aussi blanche que sa soutane. D’autres, plus inquiétantes, mettent en scène le président Emmanuel Macron, étouffé au milieu d’une foule de manifestants hostiles. Ces faux tableaux sont conçus grâce à des outils à la portée de tous. Oscillant entre fascination et inquiétude, l’observateur curieux se met à glaner sur la Toile des images créées par des machines et à interroger les acteurs impliqués. Devenu l’un des spécialistes français de ces technologies, Gilles Courtinat poursuit sa quête : comprendre toutes les implications de cette mutation irrésistible.

Comment fonctionnent les intelligences artificielles qui génèrent des images ?

Du point de vue de l’utilisateur, c’est très simple. Depuis un ordinateur, un smartphone ou une tablette, il suffit de se connecter sur une interface informatique pilotée par une intelligence artificielle, pour y saisir une suite de mots, qu’on appelle un prompt (une requête ou une invite, en français). Dans un délai très court – pas plus de quelques dizaines de secondes –, cette interface génère une image répondant à cette description. Le résultat peut atteindre un degré de photoréalisme bluffant. Ce type d’outil repose sur l’apprentissage de deux corpus : l’un est constitué de texte, l’autre, de milliards d’images trouvées sur Internet. Pour que la machine soit capable de mettre en relation correctement les mots et les images correspondantes, des ingénieurs doivent la guider dans sa phase de développement.

C’est un peu comme nous avec nos enfants. Quand ils sont petits, on leur montre l’image d’un chat dans un livre en leur expliquant, « ça, c’est un chat ». Plus tard, quand on leur redemande d’identifier cet animal, s’ils nous répondent que c’est un cheval, on leur explique que ce n’est pas le cas en leur montrant l’image d’un cheval. La machine fait exactement la même chose. Elle apprend de ses réussites et de ses échecs. Dès lors qu’elle ne commet plus d’erreur de correspondance entre le texte et l’image, elle est opérationnelle.

Quand l’idée de faire créer des images par des machines est-elle née ?

En réalité, ces technologies ne datent pas d’hier. Pendant la Seconde Guerre mondiale, le mathématicien et cryptologue de génie Alan Turing avait participé au décryptage de messages des armées allemandes grâce à un appareil mécanique de calcul, simulant les réponses d’un être humain. Au début des années 1970, le logiciel Aaron est le premier à être capable de produire des images à partir d’une commande. Au tournant des années 2000, de nombreuses recherches ont été conduites par des entreprises de cybersécurité dans le domaine de la production de texte par une intelligence artificielle, à partir d’images fournies. C’est ainsi que se développent des caméras de reconnaissance, capables de transformer ce qu’elles filment en données interprétables par l’IA. Naturellement, les chercheurs se sont interrogés : si l’on est capable de demander à des machines de décrire textuellement une image, pourquoi ne serait-il pas possible de produire une image à partir d’un texte ?

Pourquoi a-t-il fallu attendre cinquante ans entre Aaron et le boom de tous ces logiciels ?

Les capacités de calcul de nos machines ne se sont véritablement démultipliées qu’à partir du début des années 2000. Cette puissance informatique a notamment permis le développement des GAN (réseaux antagonistes génératifs, en français), des algorithmes d’apprentissage automatique qui permettent de générer des images. En 2015, des chercheurs de Toronto se sont attelés au développement de solutions text-to-image. Google sort alors DeepDream [un programme pouvant générer des images en simulant un réseau de neurones artificiels, ndlr]. La même année, l’entreprise OpenAI est créée, soutenue par les investissements de milliardaires américains comme Elon Musk. En 2021, OpenAI sort DALL-E, la première solution text-to-image. Dans la foulée, tout s’accélère avec la sortie de Midjourney [développé par un laboratoire de recherche éponyme, ndlr] en 2022.

Quelle stratégie suivent les entreprises qui développent ces outils ?

Certaines ont fait le choix de fermer l’accès à leurs outils – comme Google, avec Imagen et Parti. Probablement parce qu’elles craignent que des utilisations malveillantes nuisent à leur réputation. D’autres, comme celles qui diffusent Midjourney, DALL-E ou Stable Diffusion, développent des outils en accès grand public. L’intérêt pour eux est de toucher tous les acteurs qui ont besoin de créer des images. Et si l’on y réfléchit, ils sont nombreux : la publicité, l’édition, la presse, l’architecture, le marketing, les réseaux sociaux, vous, moi. Tout le monde, en fait. La cible est donc très large. C’est un marché potentiel de plusieurs milliards de dollars. Au début, c’était gratuit, mais les accès se restreignent au fur et à mesure. C’est un peu la stratégie des dealers de drogue qui offrent une dose pour essayer. Et une fois que le client est accro, il doit payer.

Est-ce vraiment l’arrêt de mort des métiers liés à la production d’images ?

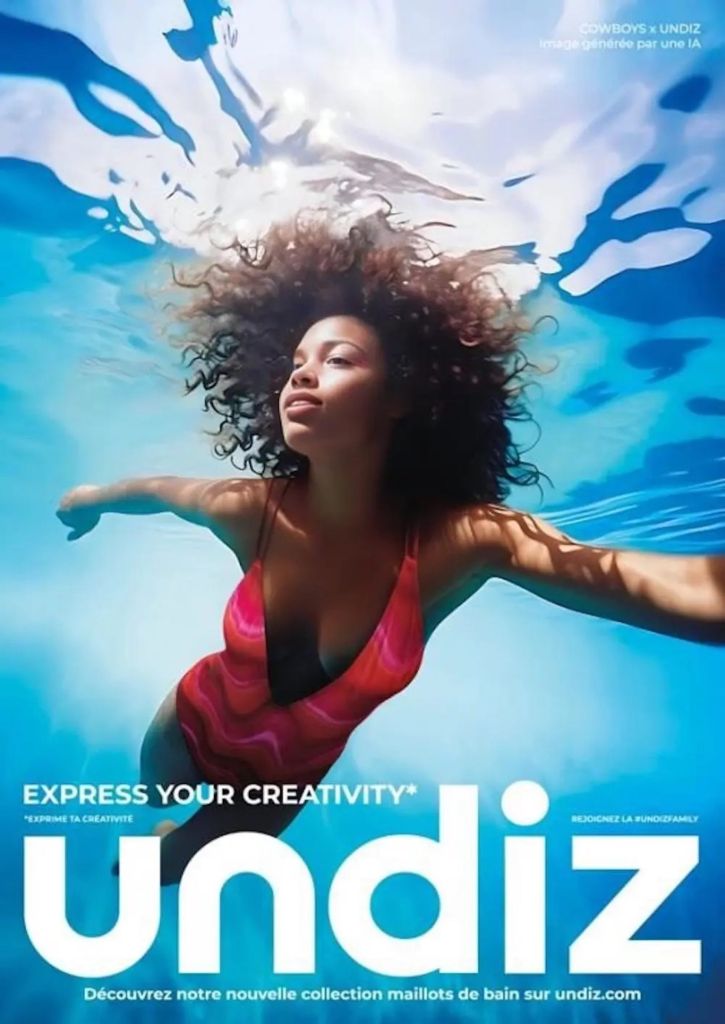

C’est un outil qui va avoir des répercussions sur l’industrie de l’image. La publicité et, plus imidement, l’édition et la presse ont commencé à utiliser cette technologie. Ils se dispensent donc de faire appel à des dessinateurs ou à des photographes. Si je peux obtenir l’image que je veux en un temps extrêmement rapide, moyennant quelques dizaines de dollars, pourquoi est-ce que j’irais m’adresser à un professionnel ? C’est plus cher, plus compliqué, et je ne peux pas toujours obtenir exactement ce que je veux.

Les banques d’images ont rapidement compris cela. Après un premier réflexe de protection, les deux mastodontes du secteur, Getty et Shutterstock, se sont alliés avec des entreprises qui développent ces technologies. Aujourd’hui, un utilisateur de leur site peut, une fois qu’il a trouvé une image qui lui convient, demander à l’IA de la modifier. D’ailleurs, le salut de certains professionnels de l’image viendra peut-être de leur capacité à appréhender l’outil. Devenir un expert en prompt de technologies text-to-image pourrait créer de nouveaux débouchés.

Car il faut avoir une certaine connaissance pour tirer réellement profit d’une technologie. C’est un peu comme les caméras des téléphones : désormais, n’importe qui peut faire une photo avec son smartphone, mais tout le monde n’est pas un bon photographe. Il faut avoir une culture, un œil, savoir ce qu’est une lumière, un cadre. C’est cette connaissance qui permet d’avoir de bons résultats. La même chose risque d’être vraie pour les utilisateurs de ces programmes.

Si les professionnels de l’image se saisissent massivement de ces outils, qui sera rémunéré ? Ceux qui ont demandé à la machine de créer la photo ?

L’intelligence artificielle voit ses capacités progresser grâce à des images faites par des êtres humains. D’où le problème du droit d’auteur. En janvier 2023, l’agence photo Getty Images a ainsi porté plainte contre la société Stability AI qu’elle accuse d’avoir pillé 12 millions de ses images pour créer le système Stable Diffusion. Pour le moment, il y a un certain flou juridique sur la question, car on ignore si cette utilisation entre dans le cadre de l’usage loyal ou si elle constitue une atteinte au copyright.

À ce propos, la Cour suprême des États-Unis a dû se prononcer récemment sur la publication d’une sérigraphie d’Andy Warhol en une d’un magazine. Cette œuvre avait été réalisée à partir d’une image de Prince prise par la photographe Lynn Goldsmith. Cette dernière a demandé que lui soient versés des droits d’auteur. Le tribunal lui a donné raison, estimant que Warhol n’avait pas assez modifié son œuvre finale.

En France, des débats similaires pourraient apparaître. Dans une procédure juridique, une personne accusée de plagiat doit prouver la nature créative de sa démarche. Il doit y avoir une vraie plus-value. Dans le domaine des images générées par logiciel, on pourrait par exemple être amené à se demander si une image a été entièrement créée par une IA ou si une

intervention humaine a été déterminante.

On a pu voir de nombreuses fausses images représentant des personnalités politiques. Les programmes d’IA générative sont-ils un outil de désinformation en puissance ?

On risque d’aboutir à une grande confusion. Actuellement, on se demande si les photographies générées par des IA sont de fausses images. Si l’on n’arrive plus à faire la distinction, on risque de se demander systématiquement si les images réelles ne sont pas générées par des machines. Là, ça devient très embêtant. Ceci dit, la question n’est pas nouvelle, les images ont été trafiquées dès la naissance de la photographie. Par exemple, on a des doutes sur les images de Roger Fenton, le premier photoreporter de guerre, pendant la guerre de Crimée, en 1855. En 1871, durant la Commune de Paris, les frères Appert ont réalisé des photomontages de bourgeois, d’ecclésiastiques et de militaires fusillés par les communards. Des régimes ont aussi effacé des personnalités sur certaines images, comme Trotsky gommé sur ordre de Staline.

Plus près de nous, il y a cette photo, censée avoir été prise le 11 septembre 2001, d’un touriste posant depuis l’une des tours du World Trade Center, avec l’un des avions détournés arrivant en arrière-plan. C’était un bête photomontage. Puis, il y a eu Photoshop, le numérique, les fonds de stock d’illustration. Jusqu’au pape François représenté en doudoune longue, aujourd’hui.

Il n’y aurait donc rien de nouveau dans ce phénomène ?

La nouveauté est qu’il n’y a plus d’intercession entre la production d’une image factice et sa diffusion. N’importe qui peut le faire, très rapidement, et à très faible coût. L’image est diffusée instantanément et se répand à une vitesse phénoménale via les réseaux sociaux, qui sont de puissants vecteurs de diffusion de fausses nouvelles. Plusieurs études ont démontré qu’une fake news sur le Web a beaucoup plus d’impact que le démenti ultérieur de cette information. Donc, une fois que c’est publié, c’est cuit. Au fond, ces logiciels sont juste de nouveaux outils, qui peuvent permettre de faire des choses

formidables ou totalement crapuleuses.

Est-il possible de freiner le développement de ces technologies ?

En mars 2023, Elon Musk et des centaines d’experts mondiaux ont signé un appel à une pause de six mois dans la recherche sur les intelligences artificielles. Mais il faut rappeler que c’est Musk qui a investi dans la fondation d’OpenAI [avant de se retirer en 2018, notamment en raison de la lente avancée du développement des outils, ndlr]. En 2019, Microsoft a investi 10 milliards de dollars dans cette entreprise pour acheter les solutions DALL-E et ChatGPT. Il aurait peut-être fallu réfléchir avant de faire ces investissements. [Non sans ambiguïté, Elon Musk a créé en 2023 la start-up d’intelligence artificielle X.AI, pour développer une alternative plus prudente aux logiciels actuellement sur le marché, ndlr].

Quelles solutions voyez-vous pour limiter la prolifération de ces images prétendument réelles ?

Une piste consisterait à obliger les prestataires de ces technologies à encrypter dans les métadonnées le fait que l’image a été fabriquée. Mais cette information ne sera pas visible, donc pas à la portée du citoyen lambda. On pourrait aussi estampiller les images, mais c’est très simple à contourner… grâce à des IA (rires). Un encadrement juridique pourrait également être envisagé, mais cela nécessiterait une harmonisation mondiale, car s’il n’y a ne serait-ce qu’un trou dans la raquette du Web, tout le monde pourra s’y engouffrer.

Une autre piste pourrait venir des photographes. Ceux-ci pourraient s’engager à labelliser leurs images auprès d’une sorte de bureau de contrôle. Cela dit, il n’est pas impossible que le développement exponentiel d’images réalisées par les intelligences artificielles remette sur le devant de la scène des images faites plus traditionnellement. Au même titre que la photographie couleur a donné une aura artistique au noir et blanc et que, plus tard, la généralisation du numérique a remis l’analogique au goût du jour.

Les plate-formes d’IA elles-mêmes prennent-elles ces enjeux éthiques à bras-le-corps ?

Certaines travaillent à améliorer les corpus d’images dans lesquels les logiciels puisent, afin de réduire les biais et d’avoir une meilleure représentation des populations humaines. Histoire d’éviter que, quand on demande l’image d’un patron, on tombe systématiquement sur un homme blanc de plus de 50 ans. Des ingénieurs de la Silicon Valley, comme ceux d’OpenAI, qui travaillent sur les risques de désinformation ont mis en place des garde-fous. Certains outils sont bridés. Par exemple, il est impossible de demander à Midjourney de produire une image de Donald Trump en train de planter un couteau dans le dos de Joe Biden.

Malgré tout, les choix restent arbitraires et fixés en interne, dans le secret industriel le plus total. Les créateurs de ces solutions ajustent le tir au fur et à mesure. De plus, cette question s’inscrit dans une lutte plus large contre les fausses informations. Les plate-formes de diffusion doivent également être responsabilisées, et donc sanctionnées si elles propagent des mensonges.

Qu’en est-il de l’éducation aux médias ? A-t-on les outils pour inciter les jeunes à la vigilance face à ces contenus ?

Il faut développer leur sens critique dès le plus jeune âge, disons à l’entrée en sixième, quand la plupart d’entre eux ont un smartphone et un accès à un ordinateur. Cette éducation doit leur permettre d’acquérir des outils intellectuels de défense contre la propagande, contre les fausses informations. Un gros effort doit être effectué, car pour l’instant cela reste modeste dans les programmes de l’Éducation nationale. Mais je ne suis pas persuadé que ce soit dans l’agenda officiel.