« Un non-sujet », avait tranché son prof de philo à la Sorbonne, en 2017. Giada Pistilli venait de proposer un mémoire sur l’éthique de l’IA. Six ans plus tard, elle répète la formule en riant. Le non-sujet est devenu sa thèse, tout juste soutenue, et surtout son métier : responsable de l’éthique dans une start-up d’intelligence artificielle, un travail encore rare en France mais qui, chez les plus gros acteurs de la Silicon Valley, occupe déjà des équipes entières.

Hugging Face, l’employeur de cette pionnière de 31 ans, au logo en forme de smiley tout sourire, arbore des résultats financiers impressionnants, sans parler de cette levée de fonds de 235 millions d’euros, réalisée l’été dernier grâce au soutien des Gafam. La chercheuse a fait son trou au bon endroit. Fondée par trois Français, l’entreprise est la première plate-forme open source qui permet à quiconque – passionnés ou professionnels – d’accéder à des modèles d’IA de pointe, pour en bidouiller de nouvelles itérations. Comme MonadGPT, un chat entraîné avec des archives du XVIIe siècle, qui devise exclusivement dans la langue et avec les connaissances de l’époque.

ChatGPT, un prisme américain

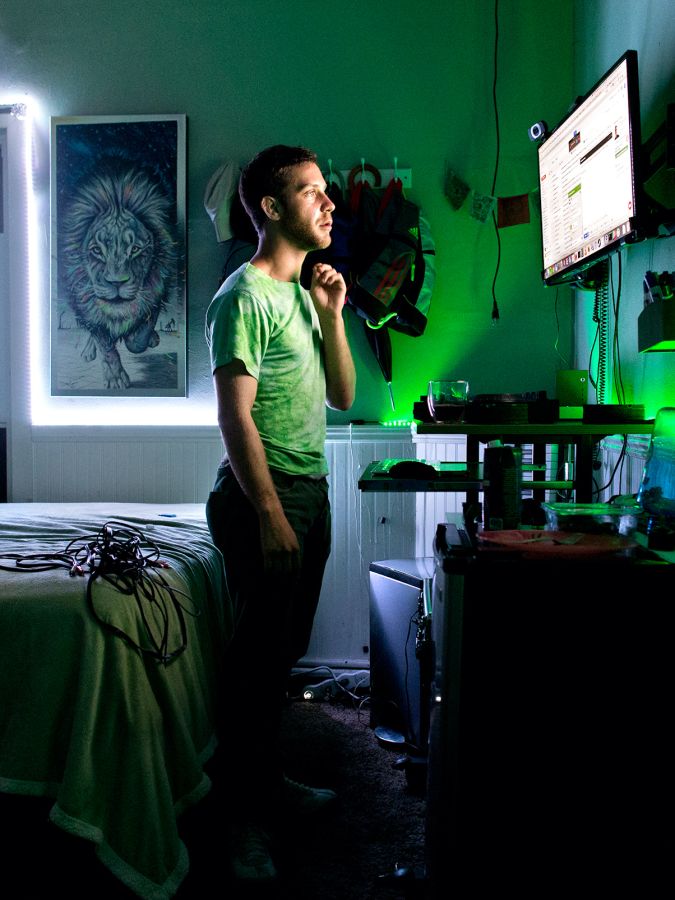

Comment une philosophe s’est-elle retrouvée au milieu de ces geeks qu’on couvre d’or ? À la fac, le cours préféré de Giada Pistilli, assuré par Michel Puech, portait sur l’éthique des technologies. « Enfin de la philo appliquée ! Les idées descendaient sur terre », se souvient-elle avec soulagement, en buvant son café dans l’open space parisien de Hugging Face, entre poufs et console Nintendo. L’enseignant, lui-même consultant en entreprise, l’encourage à mener sa thèse entre les deux mondes. En 2021, elle contribue à la rédaction de la charte éthique d’un projet participatif rassemblant le gratin de la recherche en IA, ce qui lui vaut d’être repérée.

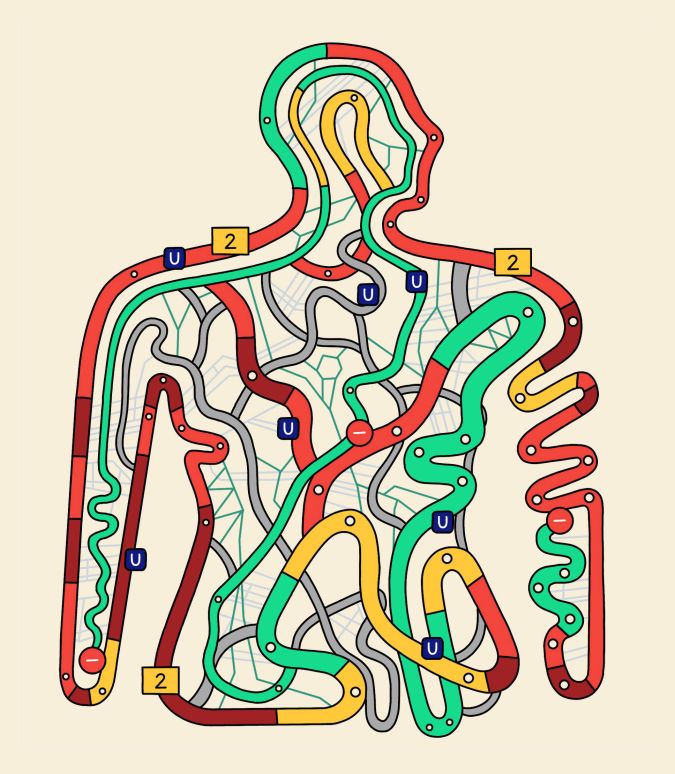

Encore doctorante, la jeune femme cosigne en 2022 un article remarqué qui démontre que ChatGPT, quelle que soit la langue dans laquelle il s’exprime, diffuse les valeurs de la société américaine. Aujourd’hui, elle se consacre toujours à la recherche, désormais pour son employeur, avec une question en fil conducteur : comment faire en sorte que l’IA se comporte bien ? Son autre tâche, c’est de s’assurer que les IA développées sur Hugging Face ne sont pas dangereuses.

Au gré de ses investigations ou de signalements internes, la philosophe navigue dans les IA de la plate-forme pour y examiner les données qui les nourrissent, ou les tester quand elles sont finalisées. Objectif : repérer les biais discriminatoires, traquer les incitations à la violence et les risques de manipulations. Elle a en tête des précédents comme Galactica, tentative ratée d’IA scientifique menée par Meta, qui a produit le plus sérieusement du monde un article sur les avantages de manger du verre pilé. « Et ça avait l’air crédible, en plus ! » L’année dernière, elle a ainsi fait fermer une version de ChatGPT, entraînée dans les forums les plus radicaux de 4chan – un site de forums anonymes –, qui déversait des insanités en ligne.

L’Italienne, cheveux coupés au carré et yeux en amande, veille sur l’IA. Mais parle-t-elle sa langue ? « J’ai commencé des cours de langage Python, je sais un peu bricoler, mais j’ai besoin qu’on m’aide », admet-elle. Quand il faut passer sous le capot, se balader dans le code pour y repérer une faille, elle passe la main à sa collègue développeuse, en Californie. « Sans sa compétence, je ne peux pas avancer. Mais elle a aussi besoin de mon regard de philosophe pour juger des implications. » Son entreprise n’est pas la seule de cet avis : Anthropic et DeepMind, deux leaders mondiaux de la recherche en IA, ont placé à des postes importants de leur branche éthique des chercheurs en philosophie. Le non-sujet est devenu un débouché.